OPC Datentransfer via Multi-Datachange-Trigger

In unserem Performance-Benchmark konnten wir gleichzeitig rund 28.500 OPC-Datenpunkte pro Sekunde an MQTT und InfluxDB übertragen. Die Übertragungsrate wurde dabei durch die Verarbeitungskapazität des OPC-Servers begrenzt, der unter höherer Last zum limitierenden Faktor wurde.

Systeme

OS: Windows Server 2019 Standard 1809

RAM: 16GB

Prozessor: 64bit 2,6GHz (4 Kerne)

OPC Router: 5.3.5008.157

OS: Windows Server 2019 Standard 1809

RAM: 12GB

Prozessor: 64bit 2,6GHz (4 Kerne)

KEPServer: V6.16.203.0

OS: Windows 10 Pro N 22H2

RAM: 12GB

Prozessor: 64bit 2,6GHz (4 Kerne)

KEPServer: V6.16.203.0

Projekte

2 KEPServerEx-Projekte

- mit jeweils einem Kanal (Simulator)

- mit jeweils einem Gerät (16 Bit Device)

- mit jeweils zwei Tag-Gruppen

- mit jeweils 40 Unter-Tag-Gruppen

- mit jeweils 200 Tags (Random 1000)

Zusammengefasst 32.000 Tags

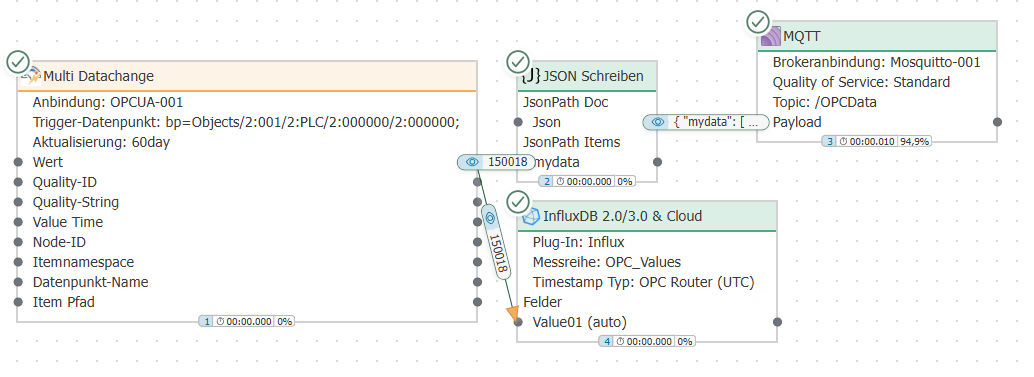

OPC Router-Projekt

- Vier OPC-UA-Client-Anbindungen (Jeweils 2 Plug-ins je KEPServerEx)

- Jedes Plug-in wird in jeweils 40 Template-Instanzen im Multi-Datachange-Trigger verwendet

- Jeder Multi-Datachange-Trigger überwacht eine Tag-Gruppe (Mit jeweils 200 Tags)

- Die bei Auslösung der Trigger jeweils gelesenen Werte werden in Influx und über MQTT weggeschrieben

Zusammengefasst: Überwachung und Auslesung von 8.000 Tags

OPC-UA-Client-Anbindung

Abweichungen vom Default:

- Subscription – OPC-Tags beim Start registrieren: true

- Erweitert – Sample Rate (ms): 1000

Multi-Datachange-Trigger

Abweichungen vom Default:

- Items aktualisieren: false

Aus Template generierte Verbindungsinstanz

Auswertung

Betrachtet wurde der durchschnittliche, zeitliche Abstand zwischen den Ausführungen der jeweiligen Multi-Datachange-Trigger.

| Verbindungen | Datenpunkte | Plug-ins | OPC Server | Ø Trigger-Abstand | Plug-in |

|---|---|---|---|---|---|

| 160 | 32000 | 4 | 2 | 1100ms | KEPServerEx 1 Anbindung #1 |

| 160 | 32000 | 4 | 2 | 1027ms | KEPServerEx 1 Anbindung #2 |

| 160 | 32000 | 4 | 2 | 1204ms | KEPServerEx 2 Anbindung #1 |

| 160 | 32000 | 4 | 2 | 1101ms | KEPServerEx 2 Anbindung #2 |

Bei einer weiteren Erhöhung der zu übertragenden Datenpunkte zeigte sich der OPC-Server als limitierender Faktor. Die Performance-Analyse ergab, dass die Verarbeitungskapazität des Servers nicht ausreichte, um höhere Lasten effizient zu bewältigen, wodurch die Gesamtübertragungsrate begrenzt wurde.

Projektdateien

Download Benchmark_Multidatachange.rpe